Sommaire

- Qu’est-ce que le budget crawl ?

- Optimiser son budget crawl : pourquoi est-ce si important en SEO ?

- Comment connaître mon budget crawl ?

- 1 – Grâce à la Google Search Console

- 2 – En surveillant l’état du crawl à l’aide des fichiers logs

- 10 techniques pour optimiser le budget de crawl de votre site

- 1 – Interdire l’exploration de vos pages les moins importantes dans le fichier robots.txt

- 2 – Mettre à jour votre sitemap

- 3 – Supprimer les pages en double

- 4 – Réduire le temps de chargement de vos pages

- 5 – Éviter les redirections en chaîne et les pages orphelines

- 6 – Supprimer les liens cassés

- 7 – Utiliser le langage HTML sur le plus de pages possible

- 8 – Ne pas utiliser de paramètres d’URL

- 9 – Utiliser les balises hreflang quand c’est nécessaire

- 10 – Mettre en place des liens internes

- Pour conclure…

Le budget crawl, c’est ce qui détermine le nombre de pages d’un site web que les robots des moteurs de recherche peuvent crawler dans un temps donné. S’il s’agit d’un point essentiel en SEO, il demeure bien trop souvent mis de côté.

En effet : lorsque le budget crawl est optimisé, les pages les plus importantes de votre site web sont mises en avant et indexées en priorité.

S’il ne l’est pas, votre site Internet peut voir sa visibilité réduite au niveau des résultats de recherche Google. Par conséquent, ce sont ses performances globales en matière de référencement naturel qui sont touchées

Néanmoins, pas d’inquiétude ! Même si vous êtes débutant, et que vous avez découvert le budget crawl il y a 5 minutes, cet article devrait vous aider à optimiser celui de votre site grâce à 10 techniques listées ci-dessous et développées dans la suite de l’article :

- Interdire l’exploration de vos pages les moins importantes dans le fichier robots.txt

- Mettre à jour votre sitemap

- Supprimer les pages en double

- Réduire le temps de chargement de vos pages

- Éviter les redirections en chaîne et les pages orphelines

- Supprimer les liens cassés

- Utiliser le langage HTML sur le plus de pages possible

- Ne pas utiliser de paramètres d’URL

- Utiliser les balises hreflang quand c’est nécessaire

- Mettre en place des liens internes

Plongeons-nous ensemble dans ce guide du budget crawl…

Qu’est-ce que le budget crawl ?

Lorsque les robots d’indexation de Google scannent votre site, ils examinent plusieurs caractéristiques :

- Vitesse du site ;

- Erreurs de serveur (ex : erreur 404) ;

- Maillage interne ;

- …

Selon ces facteurs, le moteur de recherche statuera sur le nombre de pages du site qui seront analysées.

Ainsi, le budget crawl, c’est la limite du nombre de pages explorées par les moteurs de recherche sur un seul et même site.

Un site de 10 000 pages dont le contenu est mis à jour quotidiennement pourra par exemple être scanné au moins une fois par jour ; cependant, ce crawl sera limité par le temps et les ressources allouées par le robot d’exploration.

Supposons que Google explore 500 pages de ce site chaque jour. Il lui faudrait 20 jours pour analyser tout le site. En revanche, si son budget est de 1000 pages par jour, cela lui prendrait deux fois moins de temps.

Un budget crawl plus élevé, c’est un taux d’exploration des robots d’indexation qui augmente : en d’autres termes, les robots analysent plus vite votre site.

Conséquence ? Vous augmentez vos chances d’être mieux référencé sur les résultats de recherche Google !

Optimiser son budget crawl : pourquoi est-ce si important en SEO ?

Vous l’aurez compris : le budget crawl peut s’avérer assez essentiel en termes de référencement, pouvant à la fois améliorer la visibilité de votre site web, mais également son trafic organique.

Votre objectif : peaufiner votre site Internet pour s’assurer que les robots d’indexation pourront accéder à ses pages les plus importantes, afin de les indexer efficacement.

Une optimisation de budget crawl bien réalisée vous apportera plusieurs bénéfices :

- Hausse du nombre de pages crawlées

- Hausse du nombre de pages indexées

- Hausse du trafic organique (mécaniquement)

Vous obtiendrez ces résultats notamment via une amélioration de la vitesse de votre site, la création de liens internes, la mise en ligne de votre sitemap.xml, la surveillance et le monitoring de vos erreurs serveur ou encore l’utilisation de balises canoniques.

Cependant, voyons déjà comment vous pouvez jeter un œil à votre budget crawl…

Comment connaître mon budget crawl ?

La première étape pour optimiser votre budget crawl… c’est de le connaître !

C’est une chose à laquelle je fais systématiquement attention lors de mes audits SEO.

Voici 2 techniques pour savoir combien de ressources Google et les autres moteurs de recherche allouent à votre site web.

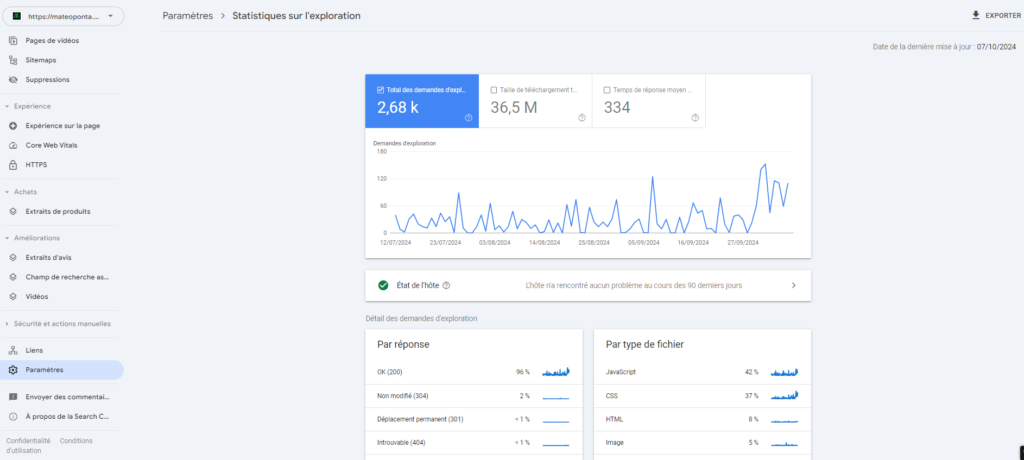

1 – Grâce à la Google Search Console

La Google Search Console, c’est tout simplement le meilleur outil SEO (et gratuit, par-dessus le marché) : outre des infos sur votre trafic, votre référencement sur Google, vos backlinks ou encore les mots-clés sur lesquels vous vous positionnez, il vous fournit de nombreuses infos sur la manière dont Google indexe votre site.

Pour cela, rien de plus simple : vous pouvez accéder au rapport “Statistiques sur l’exploration” dans vos paramètres :

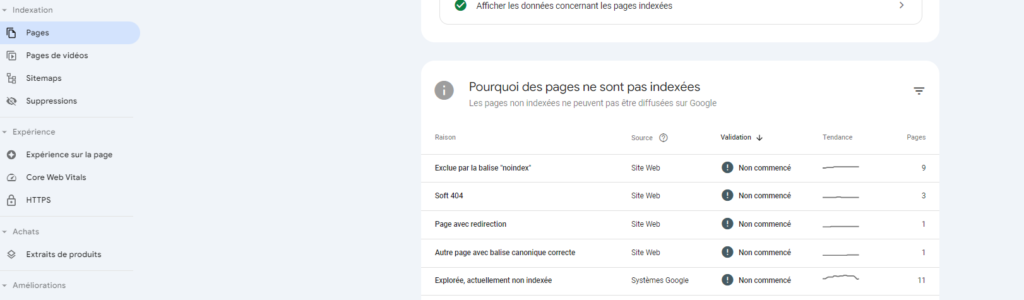

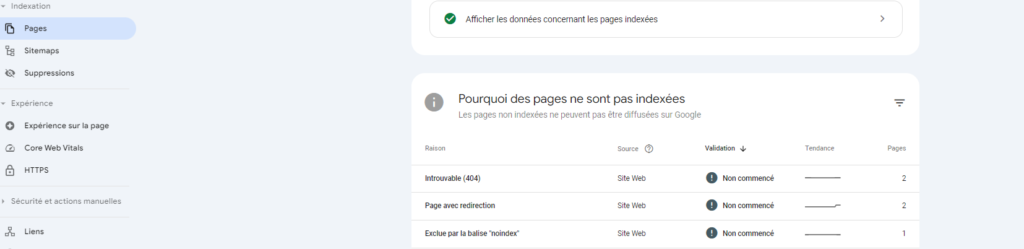

Pour voir les éventuelles erreurs qui pourraient affecter le budget crawl de votre site, rendez-vous tout simplement dans la rubrique “Indexation”, puis cliquez sur “Pages”, et regardez au niveau de “Pourquoi des pages ne sont pas indexées” :

2 – En surveillant l’état du crawl à l’aide des fichiers logs

Les logs fournissent des informations détaillées sur la manière dont les robots des moteurs de recherche parcourent votre site, notamment en vous donnant les adresses des pages analysées et la fréquence d’analyse.

En gardant un œil sur vos logs, vous pouvez facilement identifier les erreurs et les problèmes qui peuvent entraver votre budget d’exploration.

Cela étant dit, passons à mes conseils pour optimiser votre budget crawl !

10 techniques pour optimiser le budget de crawl de votre site

Il existe quelques méthodes bien connues et assez infaillibles qui vous permettront de contrôler et de maîtriser votre budget crawl.

Voyons cela, avec les 10 techniques les plus efficaces !

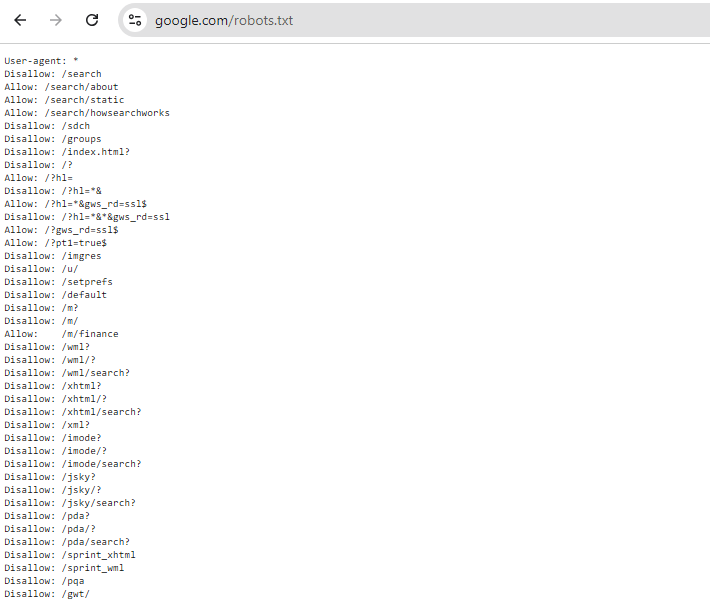

1 – Interdire l’exploration de vos pages les moins importantes dans le fichier robots.txt

La première chose à faire, c’est d’optimiser votre fichier robots.txt (← j’ai écrit un guide là-dessus; au besoin !)

En fait, les robots d’indexation utilisent le fichier robots.txt pour savoir quelles pages ils peuvent ou non analyser. Grâce aux commandes “disallow:”, vous pouvez complètement interdire l’accès à certaines pages aux robots, et ainsi optimiser votre budget crawl.

Le fichier robots.txt est visible en tapant “https://votresite.com/robots.txt”.

Attention : utilisez cela avec parcimonie ! Inutile de disallow des pages de blog qui ne font pas de visiteurs, par exemple.

Pour commencer, vous pouvez par exemple vous occuper d’empêcher les robots d’indexer vos pages “admin”, qui n’ont pas à se retrouver sur les moteurs de recherche. Pour cela, voici la commande à entrer dans votre robots.txt :

User-agent:* Disallow: /admin/Encore une fois, pour plus d’infos sur l’optimisation du robots.txt, allez voir mon article sur le sujet !

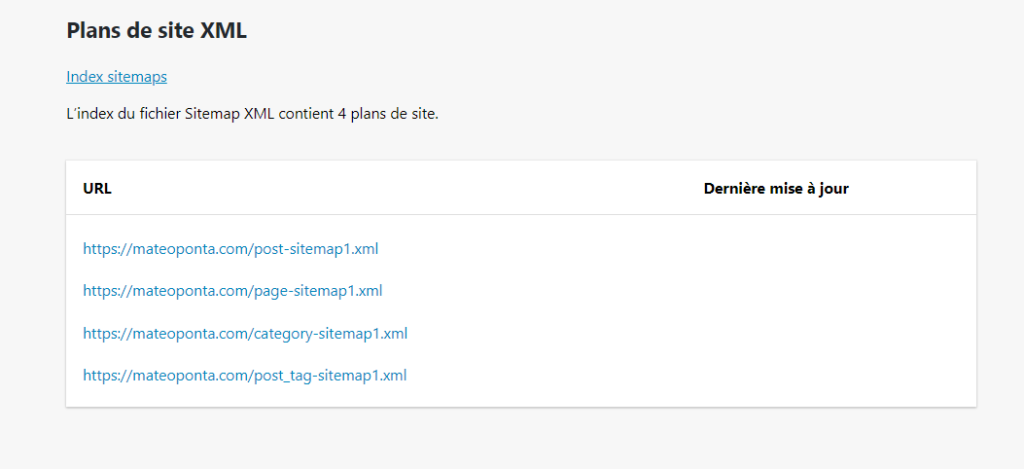

2 – Mettre à jour votre sitemap

Le sitemap, c’est un fichier qui répertorie chacune des pages importantes sur votre site Internet. Celui-ci a pour but d’aider les robots Google à visualiser la structure de votre site et à déterminer par lui-même celles qui sont les plus importantes.

Il est normalement visible sur “https://votresite.com/sitemap.xml“.

A lire également : Mon guide pour optimiser votre structure d’URL

S’il se met à jour seul via certains plug-in SEO sur WordPress (Yoast, SEOPress, RankMath, …), certains CMS nécessitent qu’ils soient mis à jour manuellement.

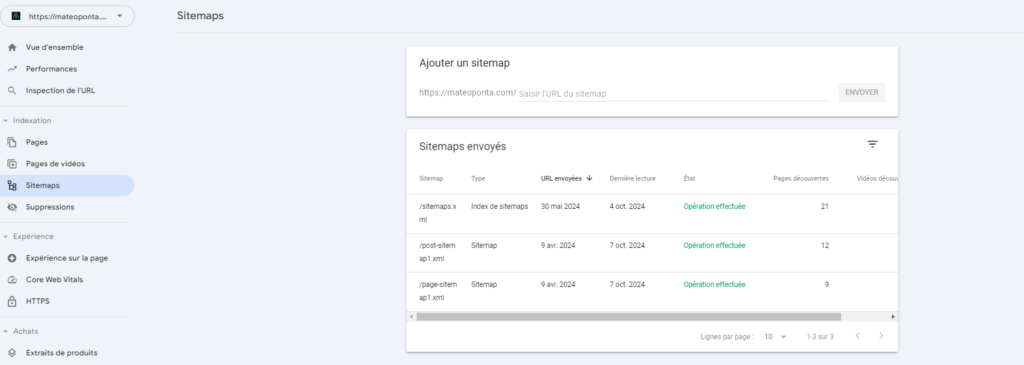

Ainsi, n’hésitez pas à le faire chaque fois que vous apportez un changement à votre site, qu’il s’agisse d’une refonte complète ou de la création d’une nouvelle page importante, puis transmettez-le à Google via la Search Console :

Ainsi, les robots d’indexation seront au courant de chaque changement sur votre site.

3 – Supprimer les pages en double

Pour optimiser votre budget crawl et empêcher Google d’analyser un même contenu plusieurs fois, vérifiez qu’aucune page n’est dupliquée sur votre site web.

Celles-ci ont au moins 4 inconvénients :

- Elles déroutent les moteurs de recherche ;

- Elles diluent votre trafic ;

- Elles gaspillent votre budget crawl ;

- Elles peuvent créer de la cannibalisation SEO.

Vous avez du contenu dupliqué sur votre site ? Pour indiquer aux moteurs de recherche quelle URL ceux-ci doivent analyser et indexer, 2 solutions s’offrent à vous :

- Supprimer le contenu dupliqué (et mettre en place une redirection 301 vers le contenu que vous gardez, puis une erreur 410 gone sur le contenu supprimé) ;

- Mettre en place une balise canonique si plusieurs URLs renvoient à la même page (ex : vous vendez des pulls, et chaque coloris correspond à une URL différente : dans ce cas, il faut choisir un coloris, et mettre en place une canonical sur cet URL).

Monitorer son duplicate content peut parfois être complexe ; si vous êtes en difficulté, n’hésitez pas à vous faire accompagner en SEO !

4 – Réduire le temps de chargement de vos pages

Comme je l’ai précisé plus haut, le temps de chargement de votre site influe directement sur votre budget crawl.

Vous n’êtes sûrement pas sans savoir que la lenteur de votre site peut affecter son SEO et son positionnement sur les mots-clés que vous ciblez. Eh bien, il en va de même pour le budget d’exploration.

Pour améliorer la vitesse de chargement des pages de votre site, plusieurs moyens existent :

- Compresser les images (les passer de .jpg ou .png à .webp, par exemple) ;

- Minifier le CSS et le JavaScript ;

- Mettre en place de la mise en cache et du lazy load ;

- …

Les possibilités sont nombreuses ; vous pouvez accessoirement jeter un œil à l’outil développé par Google, Page Speed Insight, à retrouver ici.

5 – Éviter les redirections en chaîne et les pages orphelines

Autre pratique très importante à mettre en place sur votre site pour un budget crawl optimisé : éviter les chaînes de redirection ainsi que les pages orphelines.

- Une chaîne de redirections, c’est lorsque vous faites une redirection 301 vers une page, qui fait elle-même une redirection 301 vers une page, et ainsi de suite jusqu’à arriver à la page de destination ;

- Une page orpheline, c’est une page qui n’est pas maillée sur votre site (= introuvable via un lien interne posé sur le site web).

Les redirections en chaîne et les pages orphelines ont tendance à perturber les robots d’indexation, leur faisant gaspiller une part importante de votre budget crawl.

Ainsi, veillez à ce que chaque page dispose de liens internes, et monitorez vos redirections 301 : faites en sorte que chacune fasse un lien direct vers la page de destination, et ne passe pas par des intermédiaires.

6 – Supprimer les liens cassés

Un lien cassé, c’est tout simplement un lien qui renvoie vers une erreur. Naturellement, ils sont néfastes à souhait pour votre budget crawl, dans la mesure où ils conduisent les robots d’indexation à des impasses, leur faisant perdre du temps et des ressources.

Voici des exemples de liens cassés :

- Erreur 404 : la page ou le contenu n’existe plus

- Erreur 400 : le serveur ne comprend pas l’URL

- Timeout : le serveur a dépassé le délai d’attente

- Bad Host : le serveur ne peut pas être atteint

- …

Vous pouvez avoir accès facilement à l’ensemble de ces informations via un crawl sur Screaming Frog : sa version d’essai propose le crawl de 500 URLs gratuitement !

Sinon, via la Google Search Console, vous aurez accès à l’ensemble des erreurs 404, mais aussi des soft 404. Un bon début !

7 – Utiliser le langage HTML sur le plus de pages possible

Les pages au format HTML sont plus faciles à explorer et à indexer pour les robots d’indexation que les autres types de pages.

Ainsi, au possible, faites en sorte que toutes les pages soient converties en HTML !

8 – Ne pas utiliser de paramètres d’URL

Un paramètre d’URL, c’est un élément inséré au sein de votre URL servant à donner des informations sur la page ou à filtrer des informations.

Par exemple :

- https://votresite.com/produit?couleur=rouge : ici, le paramètre d’URL démarre avec le “?” ; ce paramètre désigne un produit de couleur rouge

- https://votresite.com/produit?couleur=bleu ; cette fois, le produit est de couleur bleue

Si les paramètres d’URL peuvent donner plus de détail sur le contenu de votre page, il peut sérieusement compliquer l’indexation de votre site web de par la multiplicité des URLs créées.

Mieux vaut utiliser des URLs statiques, telles que :

- https://votresite.com/produit/rouge

- https://votresite.com/produit/bleu

9 – Utiliser les balises hreflang quand c’est nécessaire

L’attribut hreflang permet de donner une information sur la langue, voire sur la zone géographique des utilisateurs à qui s’adresse la page. Ce faisant, votre site web sera visible sur les moteurs de recherches de différents pays.

Ce conseil n’est à mettre en application que si votre site possède une version multilingue : grâce aux attributs hreflang, vos utilisateurs verront un contenu spécifique en fonction du pays depuis lequel ils vous ont recherché, automatiquement.

Cela aura pour effet… d’optimiser votre budget crawl !

10 – Mettre en place des liens internes

Si l’architecture générale de votre site est importante pour que le site soit simple à crawler par les robots, et agréable à visiter pour les êtres humains, la mise en place de liens internes mérite également que vous y accordiez une attention particulière.

Créer des liens internes sera profitable à la fois aux utilisateurs, qui pourront avoir accès à des informations complémentaires en un simple clic, mais aussi aux moteurs de recherche, qui auront plus de facilité à trouver l’ensemble de vos pages.

Comme mentionné plus haut, les pages orphelines sont les ennemies du budget crawl : vous ne devez pas en avoir sur votre site !

Autre point positif : effectuer des liens internes, c’est aussi la possibilité de mettre en place un maillage interne thématisé, permettant aux pages ciblées d’améliorer leurs positions sur Google (pensez tout de même à prendre en compte le surfer raisonnable !)

Gagnant-gagnant !

Pour conclure…

Optimiser son budget crawl est une pratique d’amélioration du référencement naturel à part entière. En effet : mieux les ressources et le temps alloué par les robots d’indexation sont utilisés sur votre site, plus celui-ci gagnera en qualité aux yeux de Google.

Si la plupart de ces conseils sont relativement simples à mettre en œuvre, d’autres peuvent nécessiter certaines compétences techniques.

N’hésitez pas à prendre contact avec moi si vous souhaitez optimiser votre site sur l’un de ces aspects, ou si vous souhaitez développer votre stratégie SEO autour d’autres axes de progression !